近日,美国加州理工学院汪立宏团队采用压缩超快光谱摄影技术(compressed ultrafastspectral photography, CUSP), 打破了该记录,实现每秒70万亿帧的拍摄技术。

这个技术有多牛,举个例子您就能明白:光速约为3000亿毫米/秒。若以70万亿帧/秒的速度除以光速,为233.3帧。换句话说,这台摄像机在光波移动1毫米的时间内可以捕获约230帧画面。

并且,汪立宏团队利用该技术首次实现了荧光寿命实时成像(single-shot spectrallyresolved fluorescence lifetime imaging microscopy,SR-FLIM)。

02 研究背景相机的成像速度从根本上限制了人类识别物理世界的能力。随着几十年的发展,基于硅的成像传感器,例如CCD和CMOS,已经可以提供高达每秒百万帧成像速度。

但是,它们在捕获各种极其快速的事件方面却不尽人意,例如超短光传播,分子的辐射衰减,冲击波传播,核聚变,光子在扩散介质中的传输等。要观察这些事件,帧速率必须超过每秒十亿帧甚至是万亿帧。

为了解决相机帧速率不足的这一问题,目前主要有两种解决思路:

1)对同一过程进行多次拍摄,然后间接描述事件的发展过程。但是这种方案只能解决发生过程保持高度一致的事件,无法实时记录事件。

2)不断提升相机的帧频率,直至达到每秒十亿帧甚至是万亿帧的速率。2011年麻省理工学院首次实现了每秒1万亿帧的拍摄技术。然后,隆德大学的FRAME相机又于2017年实现了每秒5万亿帧。紧接着,加拿大魁北克大学发明的T-CUP技术,又于2018年将该记录刷新至每秒10万亿帧。

针对第二种思路,超高速压缩摄影(CUP)是最有希望突破每秒10万亿帧速率的技术。CUP是基于压缩感知理论和条纹相机技术,不幸的是,CUP的帧速率取决于条纹相机偏转电子的能力,并且其序列深度(每次捕获的帧数,300帧)受到传感器像素数量的严格限制。

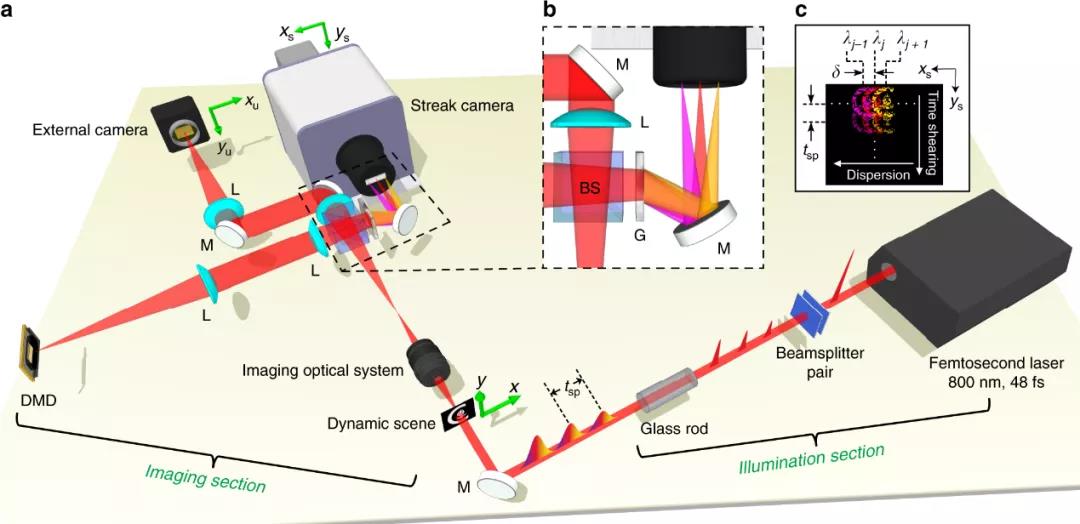

03 创新研究为了克服这一问题,汪立宏团队巧妙将CUP技术与脉冲分解技术相结合,成功研发了一种可以对超快发生的事件进行实时成像的技术—压缩超快光谱摄影技术(CUSP)(图1)。

CUSP技术利用飞秒级(10-15秒)的激光作为光源。该光源经过光学器件之后被分解为更短的闪光,从而制备了到目前为止最大序列深度的相机,帧速率可达70万亿帧/秒。

图1.CUSP系统示意图。

a)通过一对分束器和一个玻璃棒将单个飞秒脉冲转换为时间线性脉冲序列,

相邻子脉冲之间的距离为tsp(可以根据实验进行调整)。

b)光谱色散方案的详细图示(黑色虚线框)。

c) 原始CUSP图像的组成,其中包括水平方向上的光栅频谱色散和垂直方向上的条纹相机的时间剪切。

注释:BS,分束器;DMD,数字微反射镜;G,衍射光栅;L,透镜;M,反射镜。

利用一束光通过“Caltech”字样,T-CUP相机如图2(左)所示,新型CUSP相机如图2(右)所示:

图2.CUSP技术和T-CUP技术成像过程对比。

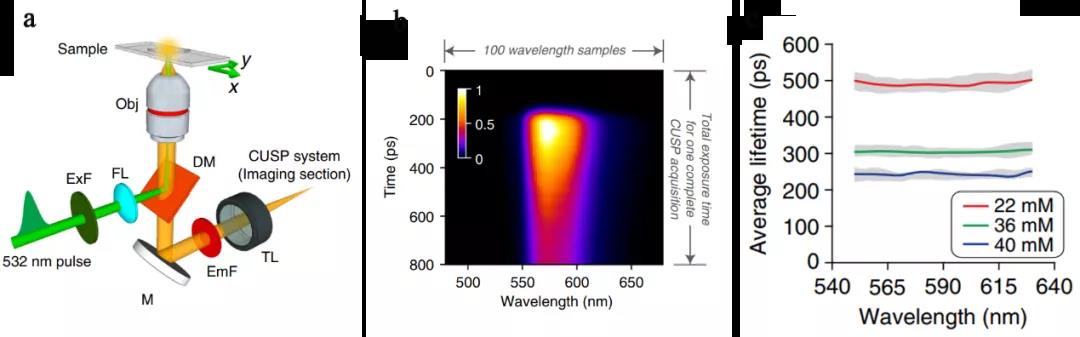

在充分验证了CUSP技术的可靠性之后,该团队利用该技术首次实现了荧光寿命实时成像(图3)。

图3.SR-FLIM设计思路及其检测结果。

a) 基于CUSP技术的SR-FLIM示意图;

b)532nm激光激发样品产生的荧光随着时间的变化关系;

c)不同浓度样品产生的荧光的平均寿命。

04 应用与展望这项技术可以为基础物理学,下一代半导体小型化和生命科学等领域开辟新的研究途径,例如超短光传播,波传播,核聚变,云和生物组织中的光子传输以及生物分子的荧光衰变。

另外,该脉冲分解提升序列深度的思路也为发展更快的超快拍摄技术的提供了新的方向。

文章信息:

相关成果以“ Single-shot ultrafast imaging attaining 70 trillion frames per second ”为题发表在 Nature communication 期刊。Peng Wang为第一作者,Lihong V. Wang (汪立宏)为通讯作者。

论文地址:

https://doi.org/10.1038/s41467-020-15745-4

原文链接:《世界最快相机诞生!每秒捕捉70万亿帧》

免责声明:

网站内容来源于互联网,由网络编辑负责审查,目的在于传递信息,提供专业服务,不代表本网站平台赞同其观点和对其真实性负责。如因内容、版权问题存在异议的,请与我们取得联系,我们将协调给予处理(按照法规支付稿费或删除),联系方式:ahos@aiofm.ac.cn 。网站平台将加强监控与审核,一旦发现违反规定的内容,按国家法规处理,处理时间不超过24小时。